Ranking del benchmark MMLU-Pro: mejor LLM en conocimiento general en 2026

- BRACAI

- 19 mar 2025

- 2 Min. de lectura

Actualizado: hace 1 día

¿Alguna vez te has preguntado qué modelo de IA es mejor en conocimiento general?

El principal benchmark para medirlo es MMLU-Pro.

Evalúa hasta qué punto los modelos de IA manejan preguntas de muchos campos académicos y profesionales.

No solo matemáticas o ciencias, sino prácticamente de todo…

Derecho. Medicina. Historia. Empresa. Ingeniería.

Es uno de los benchmarks más sólidos que tenemos para medir el razonamiento general amplio.

¿Por qué debería importarte?

El benchmark MMLU no es otro trivial más.

Es uno de los mejores indicadores indirectos que tenemos de:

conocimiento general de dominio en el que puedes confiar

capacidad de razonar a través de muchas materias

menos respuestas erróneas dadas con seguridad

mejor rendimiento en tareas profesionales del mundo real

Así que, si tu trabajo implica análisis, investigación, estrategia o toma de decisiones técnicas, estas puntuaciones son una señal útil al elegir un modelo de IA.

¿No tienes claro qué modelo escoger?

Consulta nuestra guía completa sobre los mejores LLM

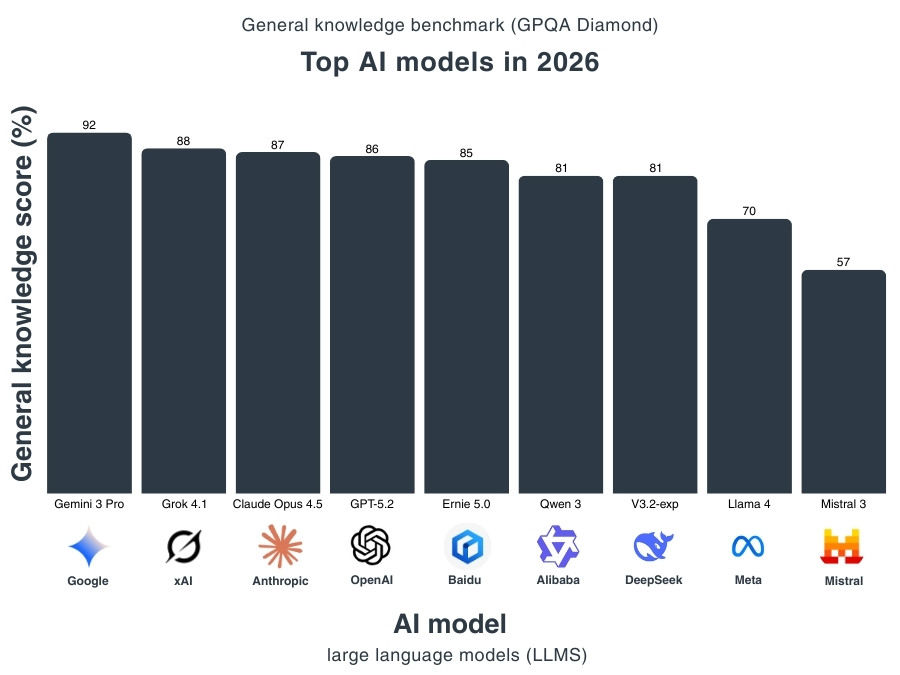

Mejor LLM en el benchmark MMLU-Pro (clasificación)

MMLU-Pro muestra algo importante: incluso con preguntas más difíciles, los modelos de frontera siguen sacando puntuaciones muy altas.

La parte alta está muy agrupada

Gemini 3 Pro lidera con un 90 %

Claude Opus 4.5 lo iguala con un 90 %

GPT-5.2 y Grok 4.1 les siguen con un 87 %

A este nivel, la pregunta ya no es: «¿Puede responder preguntas de conocimiento general?». Es: «¿Con qué fiabilidad puede razonar en dominios expertos?».

El nivel intermedio es fuerte, pero menos consistente

DeepSeek V3.2-exp obtiene un 86 %

Qwen 3 se queda en un 84 %

Sigue siendo impresionante.

Pero cabe esperar más fallos en tareas profesionales más exigentes.

La diferencia crece por debajo del grupo puntero

Ernie 5.0 obtiene un 83 %

Llama 4 y Mistral 3 se sitúan en un 81 %

Esa brecha importa si necesitas un rendimiento consistente en temas complejos como derecho, salud o ingeniería.

¿Qué es el benchmark MMLU?

MMLU significa Massive Multitask Language Understanding.

Hendrycks y colaboradores (2021) lo presentaron para evaluar cómo rinden los modelos de lenguaje en un conjunto amplio de materias.

El benchmark original incluye 57 áreas, como:

matemáticas de nivel básico

historia de Estados Unidos

informática

derecho

medicina

La puntuación final de MMLU es la precisión media en todas las tareas.

Durante años, MMLU fue uno de los principales benchmarks para medir la capacidad general de la IA.

¿Qué es el benchmark MMLU-Pro?

MMLU-Pro es la versión mejorada de MMLU.

Se introdujo porque los modelos empezaron a “saturar” la prueba original.

El nuevo benchmark aumenta la dificultad de tres formas:

12.000 preguntas de nivel posgrado

14 grandes dominios académicos

10 opciones de respuesta por pregunta en lugar de 4

MMLU-Pro se centra más en el razonamiento que en la memorización.

También reduce la sensibilidad al prompt, lo que significa que los modelos no pueden “jugar” con la prueba tan fácilmente.

Por eso MMLU-Pro importa ahora. Es uno de los pocos benchmarks que quedan y que todavía pueden separar a los mejores modelos del resto.

¿Listo para aplicar la IA a tu trabajo?

Impartimos talleres prácticos de IA y desarrollamos soluciones de IA a medida.

Comentarios